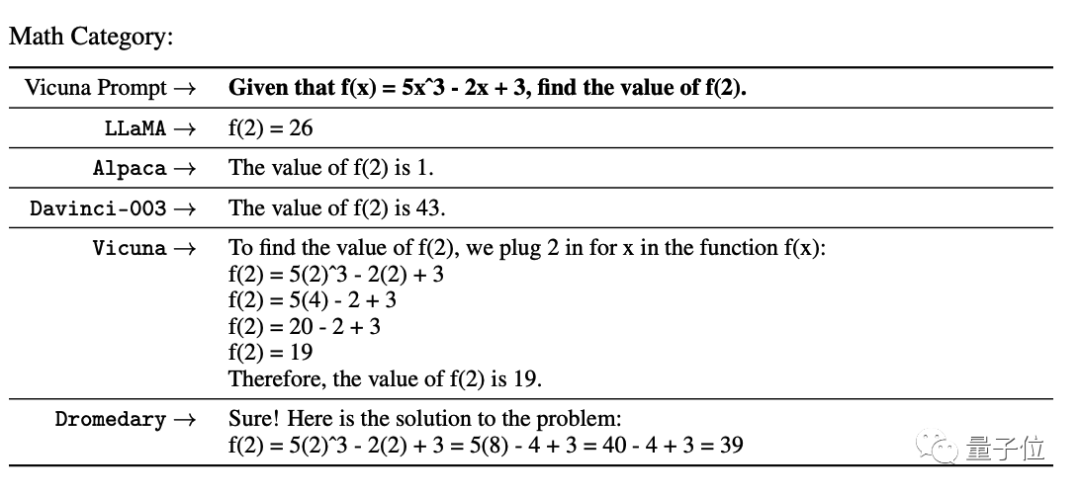

这篇文章是关于图解Transformer系列的第三篇,详细介绍了多头注意力机制的工作原理。多头注意力机制在Transformer中起着核心作用,通过将查询、键和值的参数矩阵拆分为多个注意力头并并行计算,最终合并得到最终的注意力分数。这种机制能够更好地捕捉词汇之间的联系和微妙差异,提供更丰富的表示能力。文章还介绍了注意力超参数、输入层、线性层、注意力分数计算和多头分割的过程。最后,文章指出了多头注意力机制在解码器中的应用和编码器-解码器注意力的计算过程。 url:https://mp.weixin.qq.com/s/Mdt55azb2ZAuxWNxTM8-mw

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...