AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

想要体验文生视频的小伙伴又多了一个选择!

今日,腾讯宣布旗下的混元视频生成大模型(HunYuan-Video )对外开源,模型参数量 130 亿,可供企业与个人开发者免费使用。目前该模型已上线腾讯元宝 APP,用户可在 AI 应用中的「AI 视频」板块申请试用。

腾讯混元视频生成开源项目相关链接:

- 官网:https://aivideo.hunyuan.tencent.com

-

代码:https://github.com/Tencent/HunyuanVideo

-

模型:https://huggingface.co/tencent/HunyuanVideo

-

技术报告:https://github.com/Tencent/HunyuanVideo/blob/main/assets/hunyuanvideo.pdf

腾讯混元视频生成模型 HunYuan-Video(HY-Video)是一款突破性的视频生成模型,提供超写实画质质感,能够在真实与虚拟之间自由切换。它打破了小幅度动态图的限制,实现完整大幅度动作的流畅演绎。

HY-Video 具备导演级的运镜效果,具备业界少有的多视角镜头切换主体保持能力,艺术镜头无缝衔接,一镜直出,展现出如梦似幻的视觉叙事。同时,模型在光影反射上遵循物理定律,降低了观众的跳戏感,带来更具沉浸感的观影体验。模型还具备强大的语意遵从能力,用户只需简单的指令即可实现多主体准确的描绘和流畅的创作,激发无限的创意与灵感,充分展现 AI 超写实影像的独特魅力。

总的来说,HunYuan-Video 生成的视频内容具备以下特点:

- 卓越画质:呈现超写实的视觉体验,轻松实现真实与虚拟风格的切换。

- 动态流畅:突破动态图像的局限,完美展现每一个动作的流畅过程。

- 语义遵从:业界首个以多模态大语言模型为文本编码器的视频生成模型,天然具备超高语义理解能力,在处理多主体及属性绑定等生成领域的难点挑战时表现出色。

- 原生镜头转换:多视角镜头切换主体保持能力,艺术镜头无缝衔接,打破传统单一镜头生成形式,达到导演级的无缝镜头切换效果。

AI 文生图开源生态蓬勃发展,众多创作者与开发者为生态贡献作品与插件。然而,视频生成领域的开源模型与闭源模型差距较大。腾讯混元作为第一梯队大模型,将视频生成开源,相当于将闭源模型的最强水平带到开源社区,有望促进视频生成开源生态像图像生成社区一样繁荣。

通过腾讯元宝 APP-AI 应用-AI 视频即可使用该功能(前期需申请)

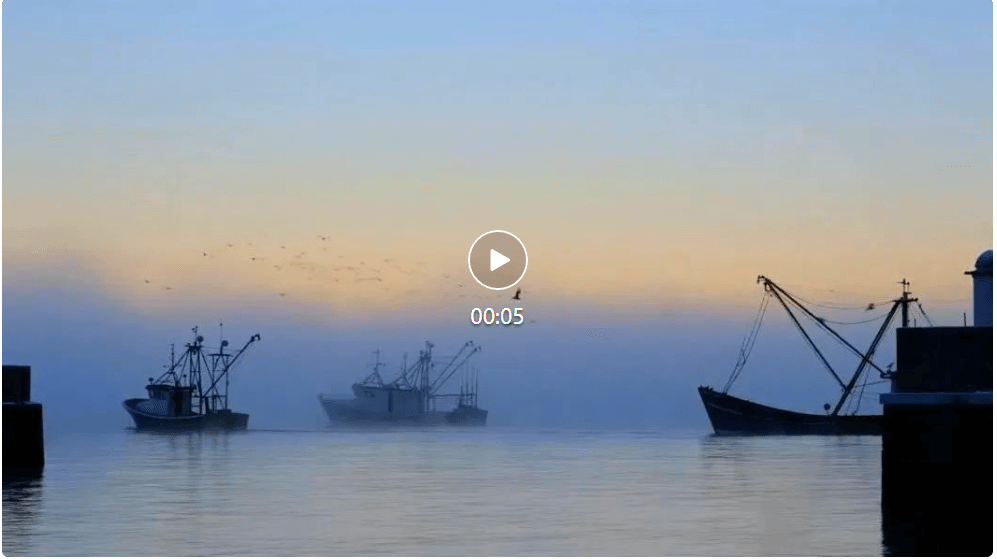

HunYuan-Video 在文生视频的画质、流畅度与语义一致性等方面都具有较高的质量。

超写实画质

通过腾讯元宝 APP-AI 应用-AI 视频即可使用该功能(前期需申请)

HunYuan-Video 在文生视频的画质、流畅度与语义一致性等方面都具有较高的质量。

超写实画质 腾讯混元视频生成模型提示词:超大水管浪尖,冲浪者在浪尖起跳,完成空中转体。摄影机从海浪内部穿越而出,捕捉阳光透过海水的瞬间。水花在空中形成完美弧线,冲浪板划过水面留下轨迹。最后定格在冲浪者穿越水帘的完美瞬间。

腾讯混元视频生成模型提示词:超大水管浪尖,冲浪者在浪尖起跳,完成空中转体。摄影机从海浪内部穿越而出,捕捉阳光透过海水的瞬间。水花在空中形成完美弧线,冲浪板划过水面留下轨迹。最后定格在冲浪者穿越水帘的完美瞬间。  腾讯混元视频生成模型提示词:穿着白床单的幽灵面对着镜子。镜子中可以看到幽灵的倒影。幽灵位于布满灰尘的阁楼中,阁楼里有老旧的横梁和被布料遮盖的家具。阁楼的场景映照在镜子中。幽灵在镜子前跳舞。电影氛围,电影打光。

原生镜头切换

腾讯混元视频生成模型提示词:穿着白床单的幽灵面对着镜子。镜子中可以看到幽灵的倒影。幽灵位于布满灰尘的阁楼中,阁楼里有老旧的横梁和被布料遮盖的家具。阁楼的场景映照在镜子中。幽灵在镜子前跳舞。电影氛围,电影打光。

原生镜头切换 视频由腾讯混元视频生成,提示词:一位中国美女穿着汉服,头发飘扬,背景是伦敦,然后镜头切换到特写镜头

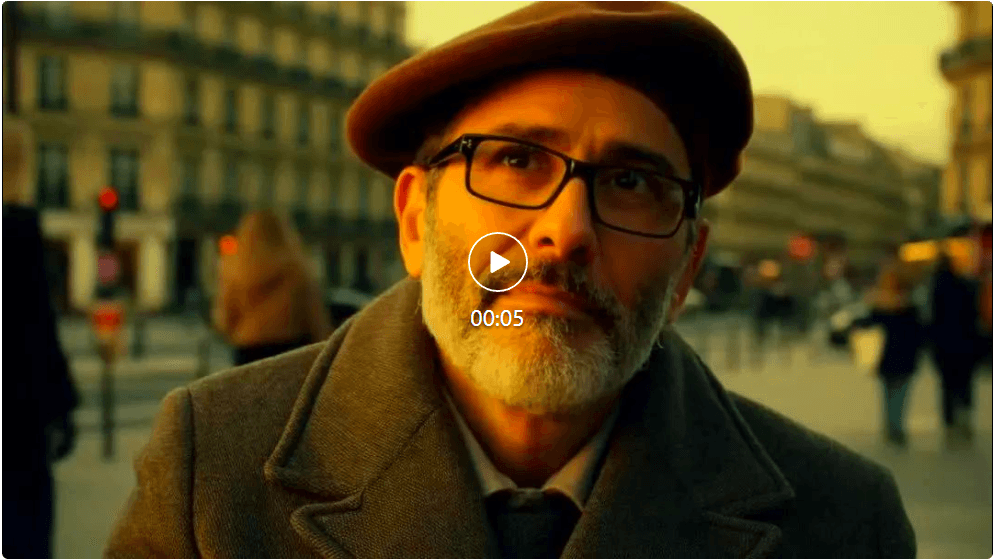

视频由腾讯混元视频生成,提示词:一位中国美女穿着汉服,头发飘扬,背景是伦敦,然后镜头切换到特写镜头 腾讯混元视频生成模型提示词:特写镜头拍摄的是一位 60 多岁、留着胡须的灰发男子,他坐在巴黎的一家咖啡馆里,沉思着宇宙的历史,他的眼睛聚焦在画外走动的人们身上,而他自己则基本一动不动地坐着,他身穿羊毛大衣西装外套,内衬系扣衬衫,戴着棕色贝雷帽和眼镜,看上去很有教授风范,片尾他露出一丝微妙的闭嘴微笑,仿佛找到了生命之谜的答案,灯光非常具有电影感,金色的灯光,背景是巴黎的街道和城市,景深,35 毫米电影胶片。

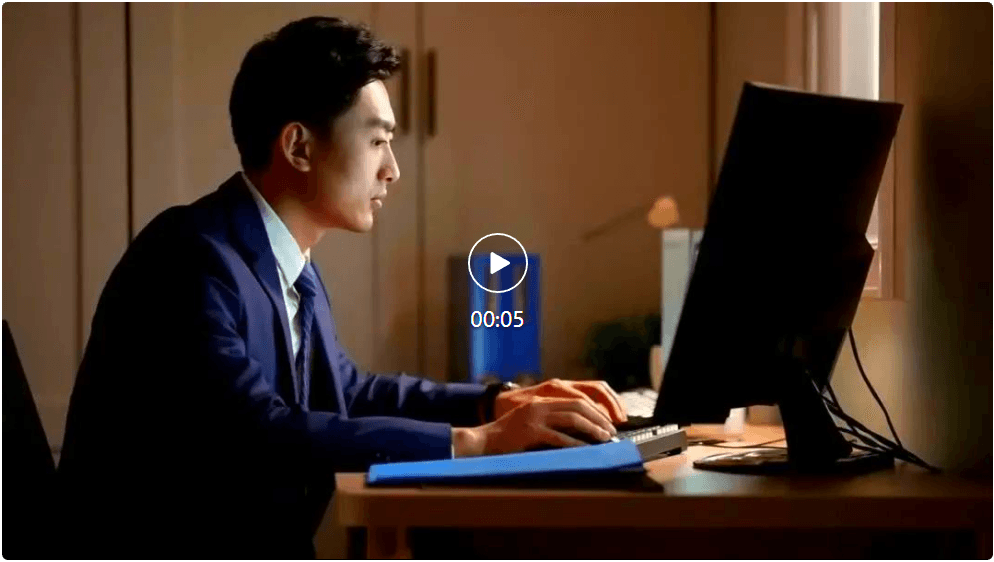

腾讯混元视频生成模型提示词:特写镜头拍摄的是一位 60 多岁、留着胡须的灰发男子,他坐在巴黎的一家咖啡馆里,沉思着宇宙的历史,他的眼睛聚焦在画外走动的人们身上,而他自己则基本一动不动地坐着,他身穿羊毛大衣西装外套,内衬系扣衬衫,戴着棕色贝雷帽和眼镜,看上去很有教授风范,片尾他露出一丝微妙的闭嘴微笑,仿佛找到了生命之谜的答案,灯光非常具有电影感,金色的灯光,背景是巴黎的街道和城市,景深,35 毫米电影胶片。 腾讯混元视频生成模型提示词:一个男人在书房对着电脑,敲打键盘,认真地工作,镜头切换到卧室里,暖黄色的灯光下,他的妻子在床边读着故事书,轻柔地拍着孩子的胸口,哄孩子入睡。温馨的氛围。

高语义一致

腾讯混元视频生成模型提示词:一个男人在书房对着电脑,敲打键盘,认真地工作,镜头切换到卧室里,暖黄色的灯光下,他的妻子在床边读着故事书,轻柔地拍着孩子的胸口,哄孩子入睡。温馨的氛围。

高语义一致 一位戴着复古飞行护目镜的机械师,半跪在蒸汽朋克风格的工作室里。她棕色卷发挽成发髻,零星的银色发丝闪着金属光泽。深棕色皮质工装背带裤上沾满机油污渍,袖口卷起露出布满齿轮纹身的手臂。特写她正用黄铜工具调试一只机械鸟,齿轮间冒出缕缕蒸汽,工作台上散落着铜管、发条和老式图纸。

一位戴着复古飞行护目镜的机械师,半跪在蒸汽朋克风格的工作室里。她棕色卷发挽成发髻,零星的银色发丝闪着金属光泽。深棕色皮质工装背带裤上沾满机油污渍,袖口卷起露出布满齿轮纹身的手臂。特写她正用黄铜工具调试一只机械鸟,齿轮间冒出缕缕蒸汽,工作台上散落着铜管、发条和老式图纸。 固定机位的老公寓内景,自然光透过纱帘漫射,青色街灯渗入,茶烟袅袅升起,老式家具静静陈列,定格岁月流逝的时光。

基于腾讯混元的开源模型,开发者及企业无需从头训练,即可直接用于推理,并可基于腾讯混元系列打造专属应用及服务,能够节约大量人力及算力。同时,各大模型研发团队均可基于腾讯混元模型进行研究与创新,加速行业创新步伐。

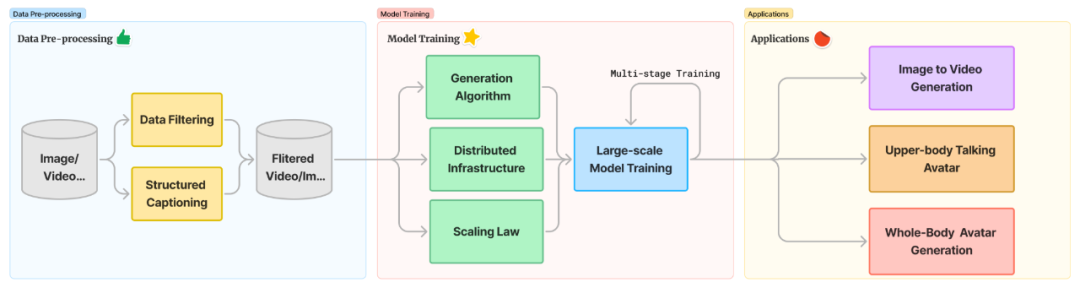

据技术报告,在混元视频生成模型架构设计与训练中,采用了多个创新技术:包括通过新一代本文编码器提升语义遵循,自研 3D 视觉编码器支持图像视频混合训练,通过全注意力机制提升画面运镜能力,并根据自研的图像视频 Scaling Law 设计和训练了最优配比模型。

Hunyuan-Video 是一个综合的视频训练系统,涵盖了从数据处理到模型部署的各个方面。本技术报告介绍了我们的数据预处理技术,包括数据过滤算子和重新标注模型,并详细说明了 Hunyuan-Video 所有组件的架构,和我们发现的视频生成模型 scaling law,以及我们的训练和推理策略。

我们讨论了加速模型训练和推理的方法,使得开发一个拥有 130 亿参数的大型模型成为可能,并评估了我们的文本到视频基础模型的性能,与最先进的视频生成模型(包括开源和专有模型)进行了比较。

最后,我们展示了基于预训练基础模型构建的各种应用,并附上相关的可视化效果。

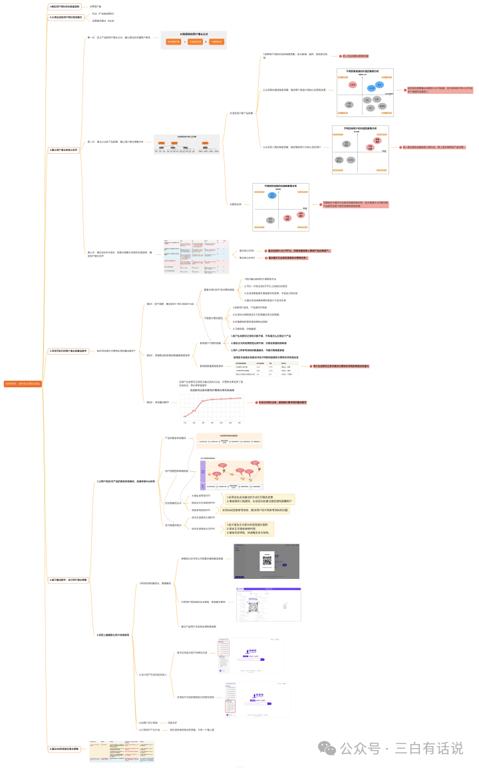

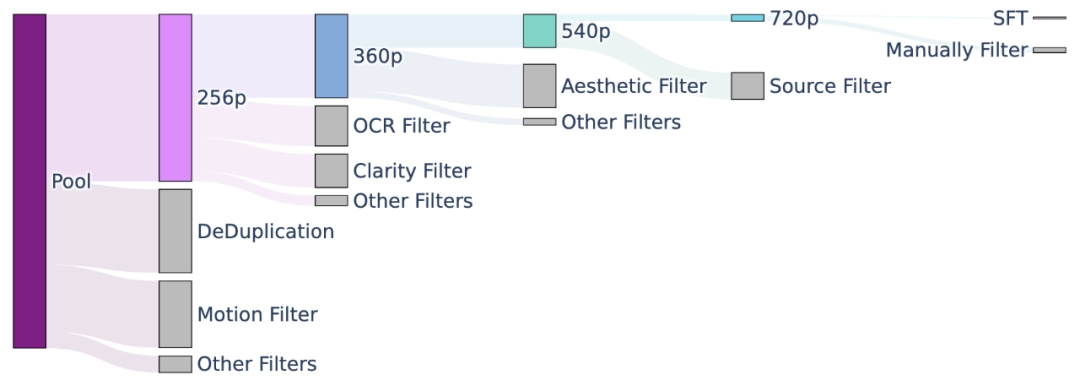

我们采用自动化数据过滤和人工过滤相结合的方式,从粗到细构建多个阶段训练数据集。在 256p、360p、540p 和 720p 训练阶段,采用各种过滤器对图片、视频数据过滤,并逐步提高过滤算子的阈值。在 SFT 阶段训练阶段,采用人工过滤的方式以充分保障训练数据质量。

该图突出显示了在每个阶段使用的一些最重要的过滤器。在每个阶段,将会移除大量数据,移除的比例从前一阶段的数据的一半到五分之一不等。在这里,灰色条表示每个过滤器过滤掉的数据量,而彩色条则表示每个阶段剩余的数据量。

首个适配 MLLM 作为文本编码器的视频生成模型,具备强大的语义跟随能力,可以轻松应对多个主体描绘。

在文生图和文生视频等视觉生成模型中,负责处理文本、理解文字的文本编码器起着关键作用。目前行业中大部分的视觉生成模型的文本编码器,适配的主要是上一代语言模型。

混元视频生成是业界适配最新一代大语言模型 MLLM (Multimodal Large Language Model)作为文本编码器的视频生成模型,具备强大的语义跟随能力,更好地应对多个主体描绘,实现更加细节的指令和画面呈现。

固定机位的老公寓内景,自然光透过纱帘漫射,青色街灯渗入,茶烟袅袅升起,老式家具静静陈列,定格岁月流逝的时光。

基于腾讯混元的开源模型,开发者及企业无需从头训练,即可直接用于推理,并可基于腾讯混元系列打造专属应用及服务,能够节约大量人力及算力。同时,各大模型研发团队均可基于腾讯混元模型进行研究与创新,加速行业创新步伐。

据技术报告,在混元视频生成模型架构设计与训练中,采用了多个创新技术:包括通过新一代本文编码器提升语义遵循,自研 3D 视觉编码器支持图像视频混合训练,通过全注意力机制提升画面运镜能力,并根据自研的图像视频 Scaling Law 设计和训练了最优配比模型。

Hunyuan-Video 是一个综合的视频训练系统,涵盖了从数据处理到模型部署的各个方面。本技术报告介绍了我们的数据预处理技术,包括数据过滤算子和重新标注模型,并详细说明了 Hunyuan-Video 所有组件的架构,和我们发现的视频生成模型 scaling law,以及我们的训练和推理策略。

我们讨论了加速模型训练和推理的方法,使得开发一个拥有 130 亿参数的大型模型成为可能,并评估了我们的文本到视频基础模型的性能,与最先进的视频生成模型(包括开源和专有模型)进行了比较。

最后,我们展示了基于预训练基础模型构建的各种应用,并附上相关的可视化效果。

我们采用自动化数据过滤和人工过滤相结合的方式,从粗到细构建多个阶段训练数据集。在 256p、360p、540p 和 720p 训练阶段,采用各种过滤器对图片、视频数据过滤,并逐步提高过滤算子的阈值。在 SFT 阶段训练阶段,采用人工过滤的方式以充分保障训练数据质量。

该图突出显示了在每个阶段使用的一些最重要的过滤器。在每个阶段,将会移除大量数据,移除的比例从前一阶段的数据的一半到五分之一不等。在这里,灰色条表示每个过滤器过滤掉的数据量,而彩色条则表示每个阶段剩余的数据量。

首个适配 MLLM 作为文本编码器的视频生成模型,具备强大的语义跟随能力,可以轻松应对多个主体描绘。

在文生图和文生视频等视觉生成模型中,负责处理文本、理解文字的文本编码器起着关键作用。目前行业中大部分的视觉生成模型的文本编码器,适配的主要是上一代语言模型。

混元视频生成是业界适配最新一代大语言模型 MLLM (Multimodal Large Language Model)作为文本编码器的视频生成模型,具备强大的语义跟随能力,更好地应对多个主体描绘,实现更加细节的指令和画面呈现。

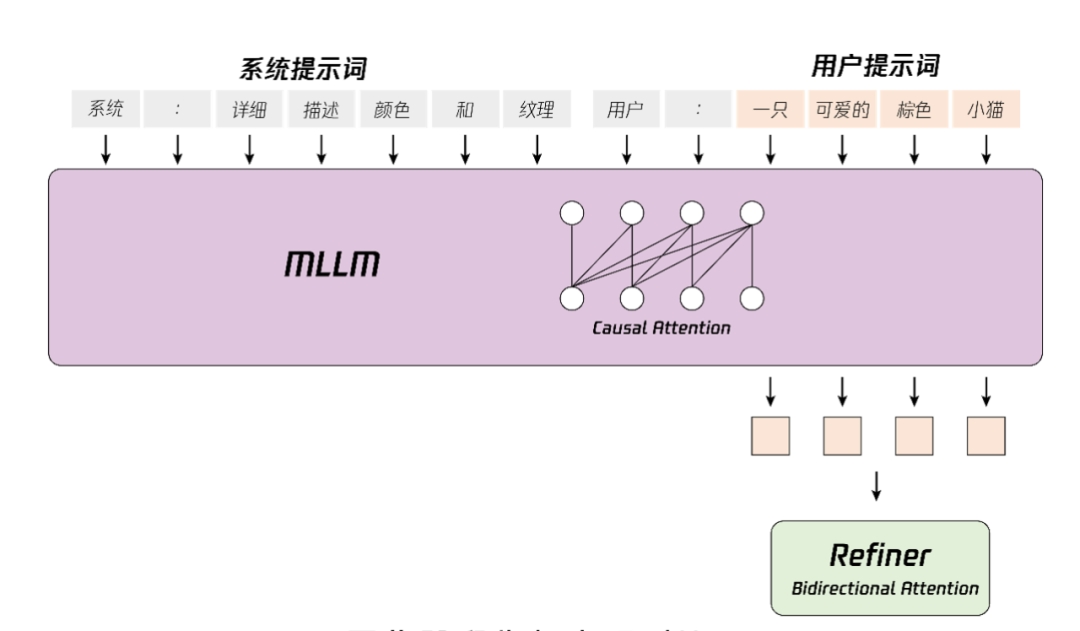

文本到视频等生成任务中,文本编码器在隐式表征空间中提供的指导信息起着关键作用。业界常见模型通常使用预训练的 CLIP 和 T5 作为文本编码器,其中 CLIP 使用 Transformer Encoder,而 T5 使用的是 Encoder-Decoder 结构。相比之下,我们利用最先进的多模态大语言模型(MLLM)进行编码操作,它具有以下优势:

(1)与 T5 相比,MLLM 在视觉指令微调后的表征空间中具有更好的图像 – 文本对齐性,这减轻了扩散模型中指令跟随的难度;

(2)与 CLIP 相比,MLLM 在图像细节描述和复杂推理方面有着更加优越的能力;

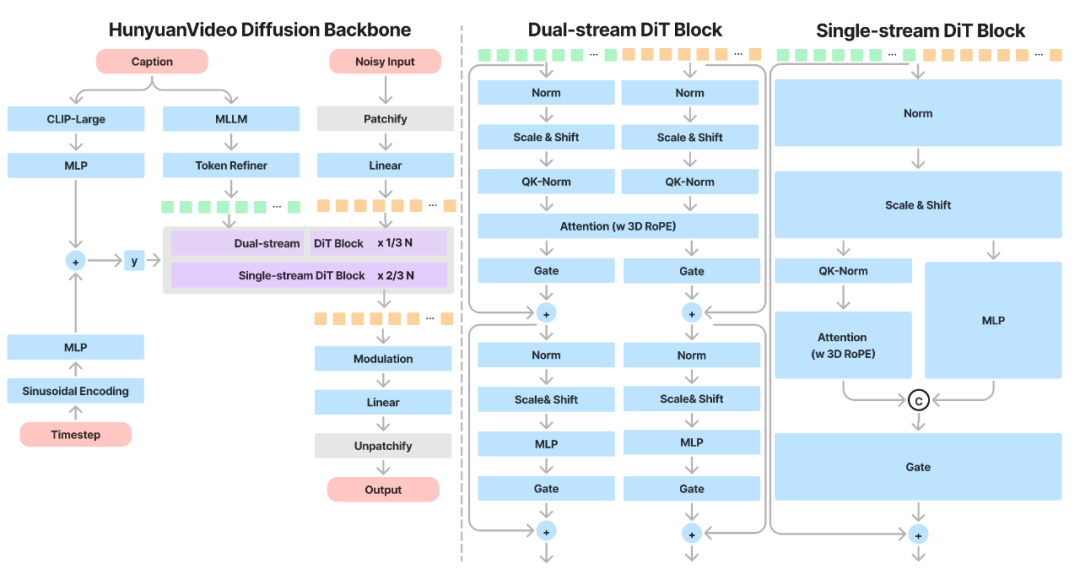

(3)MLLM 可以通过设计系统指令前置于用户提示来充当零样本学习器,帮助文本特征更加关注关键词。此外,如图 8 所示,MLLM 基于因果注意力,而 T5-XXL 利用双向注意力,为扩散模型产生更好的文本指导。因此,我们遵循的方法,引入了一个额外的双向令牌细化器,以增强文本特征。此外,CLIP 文本特征也是文本信息的摘要。如图所示。我们采用了 CLIP-Large 文本特征的最终非填充令牌作为全局指导,将其整合到双流和单流的 DiT 块中。

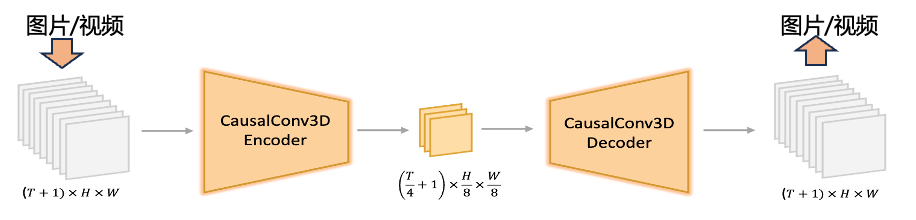

通过自研的 3D 视觉编码器支持混合图片和视频训练 / 先进的图像视频混合 VAE(3D 变分编码器),让模型在重建能力场景有明显提升,具备小人脸和动作的极高上限。

视觉编码器在压缩图片 / 视频数据,保留细节信息方面起着关键作用。混元团队通过自研的 3D 视觉编码器支持混合图片 / 视频训练,同时优化了编码器训练算法,显著提升了编码器在快速运行、纹理细节上的压缩重建性能,使得视频生成模型在细节表现上,特别是小人脸、高速镜头等场景有明显提升

从头到尾用 full attention(全注意力)的机制,没有用时空模块,提升画面流畅度。

混元视频生成模型采用基于单双流模型机制的全注意力网络架构,使得每帧视频的衔接更为流畅,并能实现主体一致的多视角镜头切换。与「分离的时空注意力机制」分别关注视频中的空间特征和时间特征,相比之下,全注意力机制则更像一个纯视频模型,表现出更优越的效果。其次,它支持图像和视频的统一生成,简化了训练过程并提高了模型的可扩展性。最后,它更有效地利用了现有的大型语言模型(LLM)相关的加速能力,从而提升了训练和推理的效率。

根据自研的图像视频 Scaling Law 设计和训练了最优配比模型。

Scaling Law 通常用来描述模型性能如何随着模型大小、训练数据和计算资源的增加而变化。在人工智能研究的早期,训练模型往往需要在诸多超参数之间反复尝试,而 Scaling Law 提供了指导如何扩展这些参数的经验公式,使模型达到更好的性能。

Scaling Law 在 AI 领域的应用非常广泛。尤其是在大模型的训练中,帮助科学家们确定,如果需要模型有更好的表现,应该优先增加模型参数、训练数据的规模还是训练计算量。

Google、OpenAI 等领先的科技公司对 Scaling Law 进行了大量的探索,这些研究为现代大型 AI 模型的成功奠定了基础。但是多模态模型领域(如图像、视频、音频等)的 Scaling Law 尚没有被真真切切地验证过。

腾讯混元团队在过亿级别的图像视频数据上,较为系统的训练验证了图像视频生成模型的 Scaling Law。根据我们的发现,我们可以准确的设计出最优的模型参数 / 数据 / 算力配比,也给了后续学术界和业界开发更大规模模型一个经验公式,到底什么样规模的模型需要多少训练数据和算力,使模型达到更好的效果性能,可以推动业界在视频生成领域的发展。

从年初以来,腾讯混元系列模型的开源速度就在不断加快。

5 月 14 日,腾讯宣布旗下的混元文生图大模型全面升级并对外开源,这是业内首个中文原生的 DiT 架构(DiT,即 Diffusion With Transformer)文生图开源模型,支持中英文双语输入及理解,参数量 15 亿,整体能力属于国际领先水平。

11 月 5 日,腾讯混元宣布最新的 MoE 模型「混元 Large」以及混元 3D 生成大模型「Hunyuan3D-1」正式开源。

Hunyuan-Large 总参数量约 389B,激活参数量约 52B,文本长度 256k。这是当前业界参数规模最大、效果排名第一的 MoE 开源模型。其在 CMMLU、MMLU、CEval、MATH 等多学科综合评测集以及中英文 NLP 任务、代码和数学等 9 大维度全面领先,超过 Llama3.1、Mixtral 等一流的开源大模型。

混元 3D 生成大模型则是首个同时支持文字、图像生成 3D 的开源大模型。一期开源模型包含轻量版和标准版,轻量版仅需 10s 即可生成高质量 3D 资产。该模型在今年年初已在腾讯内部上线发布并应用于实际业务中,如 UGC 3D 创作、商品素材合成、游戏 3D 资产生成等。

本次视频生成大模型的开源,也是腾讯混元拥抱开源,用技术反馈社区的一大成果。至此,腾讯混元全系列大模型已实现全面开源。

腾讯在开源上一直持开放态度,已开源了超 170 个优质项目,均来源于腾讯真实业务场景,覆盖微信、腾讯云、腾讯游戏、腾讯 AI、腾讯安全等核心业务板块,目前在 Github 上已累计获得超 47 万开发者关注及点赞。

腾讯混元也会继续保持开放,将更多经过腾讯应用场景经验的模型开源出来,促进大模型生态的繁荣发展。

未来我们会开源更多基于视频创作生态的模型,这里小小剧透一些片段。

腾讯混元视频生成模型提示词:超大水管浪尖,冲浪者在浪尖起跳,完成空中转体。摄影机从海浪内部穿越而出,捕捉阳光透过海水的瞬间。水花在空中形成完美弧线,冲浪板划过水面留下轨迹。最后定格在冲浪者穿越水帘的完美瞬间。

腾讯混元视频生成模型提示词:超大水管浪尖,冲浪者在浪尖起跳,完成空中转体。摄影机从海浪内部穿越而出,捕捉阳光透过海水的瞬间。水花在空中形成完美弧线,冲浪板划过水面留下轨迹。最后定格在冲浪者穿越水帘的完美瞬间。

视频由腾讯混元视频生成,提示词:一位中国美女穿着汉服,头发飘扬,背景是伦敦,然后镜头切换到特写镜头

视频由腾讯混元视频生成,提示词:一位中国美女穿着汉服,头发飘扬,背景是伦敦,然后镜头切换到特写镜头

语音驱动数字人

语音驱动数字人  姿态控制

姿态控制